从数据中心建设阶段和运营阶段整体降低碳排放

研究降低数据中心整体碳排放的相关创新技术,需要首先对数据中心这个整体概念进行解构。

从数据中心的生命周期维度分析碳排放,基本可以划分为两个阶段:

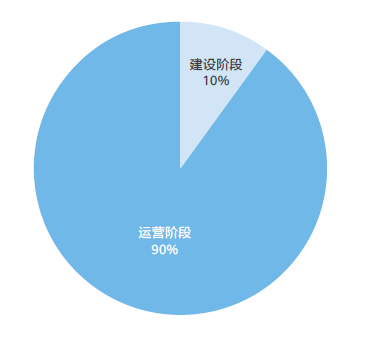

第一是建设阶段:在数据中心正式投入运营之前,需要进行大量的土地作业、建筑工程以及设备调试等工作,这个阶段将会产生一部分的碳排放,而且建筑材料和相关设备在生产和回收时产生的碳排也会对总体碳排产生影响;

第二是运营阶段:这一阶段产生的碳排放包括由 ICT 设备工作消耗电能所产生的间接碳排放,以及备用柴油发电机等基础设施产生的直接碳排放,这一阶段碳排放的总量取决于各类设备的耗电量、可再生能源的利用比例,以及数据中心整个运行生命周期的时长。

以一个 1500 柜,每柜 8kW,负载率 75%,PUE 设计值为 1.5 的数据中心为例,其 10 年生命周期碳排放约 76.3万吨,其中包含建设阶段排放约 10%,相关减碳技术主要体现在数据中心设计和建设模式上,而占 90%的运营阶段碳排放以用电为主,此部分的减碳技术主要体现在设备高效节能技术上。(计算方法参考中华人民共和国生态环境部《关于做好 2022 年企业温室气体排放报告管理相关重点工作的通知》,全国电网排放因子为 0.5810tCO2/MWh)。

因此,按数据中心生命周期的不同阶段,可以将相关绿色节能技术划分为设计建设阶段和运营阶段两类。

图1 数据中心建设与运营过程产生碳排比例

设计建设阶段采用的技术

1.数据中心 PUE 仿真设计技术

PUE 仿真设计源于创新数字孪生理念,在设计阶段,基于方案构建设备模型、系统模型,并且基于导入的运行参数和外部数据(如负载率、气候数据)来模拟系统和设备运行状态,输出重点特征值状态 PUE。采用一维热流体仿真技术对数据中心制冷系统进行物理建模,结合控制仿真技术模拟系统的控制过程,最终获取 AHU(Air Handling Unit,空气处理单元)、冷机、冷塔、水泵等制冷设备的动态和稳态状态,实现复杂热流系统的状态重现和预测。PUE 仿真设计也可以用于数据中心运营过程中系统智能 PUE 调优时的 PUE 预测仿真。

2.预制模块化建设技术

以全栈化的思维融合数据中心土建工程(L0)及机电工程(L1),功能区域采用全模块化设计,将结构系统、供配电系统、暖通系统、管理系统、消防系统、照明系统、防雷接地、综合布线等子系统预集成于预制模块内,所有预制模块在工厂预制、预调测,并在现场同步进行地基土建建设作业。交付过程中,预制功能模块从工厂运输到站点现场,无需进行大规模土建,只需要进行简单吊装及乐高式搭建,即可完成数据中心快速建设部署,相比传统方式上线时间提前50%,有效降低建设过程中的建筑垃圾、施工用水产生,同时在生命周期结束后材料回收率高于80%,具有全生命周期低碳的优势。

3.数据中心园区叠光和叠储技术

对于大部分数据中心应用场景而言,数据中心园区叠光通常适合作为市电的补充,可以有效帮助客户降低一部分的运营费用的支出。

同时,随着各地峰谷电价差的逐步放大,会有效激发数据中心企业在园区建设储能装置,一方面可以削峰填谷,在波谷期间用市电给储能装置充电,波峰期间使用储能装置给数据中心供电,利用峰谷电价差实现套利;另一方面可以更好的适应未来新能源占比逐步走高的供电网络,实现本地的调峰调频,有力的保障负载设备更稳定的运行。

运营阶段采用的技术

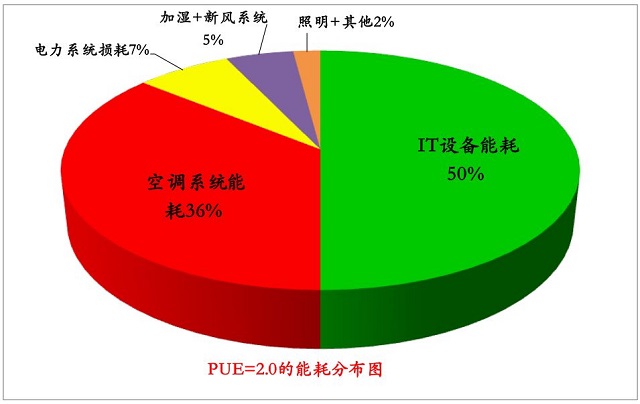

数据中心运营过程中的节能降碳技术分析,可以从电能消耗的组成部分维度切入。对于一个典型的数据中心,运营过程的电力消耗是由服务器、存储和网络等 ICT 设备,空调和换热器等制冷设备、变电设备,UPS(Uninterruptible Power Supply,不间断电源)、备用发电机和电池等供配电设施以及照明、监控等其他设备所产生的。图 2 以一个 PUE=1.5 的数据中心为例,其中67% 的电力消耗来自 ICT 设备功耗,27% 来自制冷系统功耗,5% 功耗由供配电损耗和 1% 由其他设备产生。

图2 一个PUE=1.5的数据中心中各组成部分所消耗的电能占比

1.制冷设备节能技术

随着芯片技术与工艺的进步,服务器计算能力有了数十倍的增长,但是总体功耗也随之提升。预计到 2025 年,数据中心的 x86 CPU 芯片 TDP(Thermal Design Power,散热设计功耗 ) 提升至350W 左右,ARM CPU 芯片的 TDP 提升至 600W 左右,而用于人工智能计算的 NPU/GPU 芯片会提升到 750W 左右。同时期对应的典型服务器 (2U 高度 2 路处理器 ) 功率也持续演进,x86 CPU 服务器会提升到 725W 左右,ARM CPU 服务器提升至 1000W 左右,用于人工智能计算的 NPU/GPU服务器会提升到 1500W 左右。基于这些预测,2025 年主流机柜功率将会达到 12~15kW/ 柜,未来会继续增加到 25kW-50kW/ 柜,甚至更高,对当前的数据中心制冷技术带来极大挑战。

对应的数据中心制冷设备技术包括直接自然风冷却、间接蒸发冷却、冷板式液冷和浸没式液冷等,15kW/ 柜以下风冷技术可以满足大部分地区的制冷需求,出现自然冷源代替冷冻站等传统人工冷源趋势,间接蒸发冷却可以在中国大部分地区实现平均 PUE 低于 1.25 的目标。15kW/ 柜以上时风冷技术成本上升,液冷技术开始具备经济性。液冷目前最主流的方式冷板式液冷和浸没式液冷,当前主要用于高功率密度型业务如 HPC(High Performance Computing,高性能计算 ) 和人工智能计算,通常单机柜功率超过 20kW。而随着通用计算 CPU 的功率密度提升,通用计算使用的高功率密度服务器液冷技术出现规模应用的机遇。

除风冷技术和液冷技术之外,制冷设备节能技术还有很多,包括最新的氟泵、余热回收、吸附式制冷、相变蓄冷和数据密集型集群存储等创新技术,由于大多尚处于早期,且受到产业链成熟度、投资成本、运营运维成本、运维难度和适用等条件限制等原因,尚未形成规模应用。

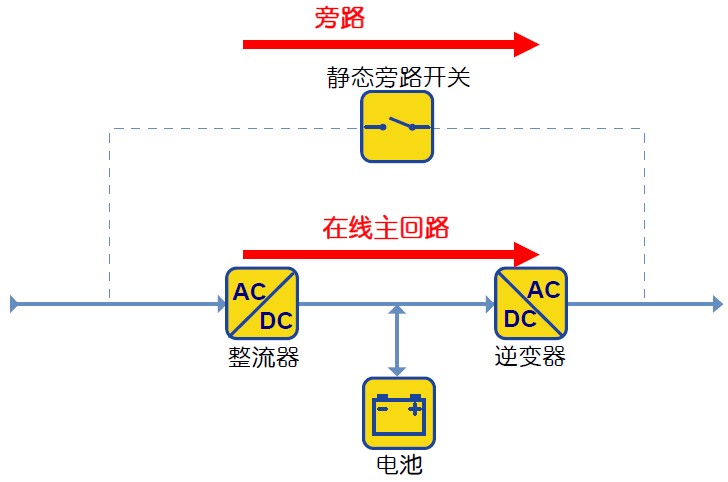

2.供配电设备节能技术

供配电设备的节能技术包括:高效 UPS,UPS 智能在线模式,电力模块等。这些节能技术已经通过互联网企业的实践逐步进入了规模化应用,助力降低供配电损耗。电力电子半导体技术出现得较晚,但发展迅速,短短几十年,已经经历了晶体管、晶闸管(SCR Silicon Control Rectifier 和GTO Gate Turn-Off Thyristor)、金氧半场效晶体管(MOSFET Metal-Oxide-Semiconductor Field-Effect Transistor)、绝缘栅双极型晶体管(IGBT Insulated Gate Bipolar Transistor)几次迭代。近年宽禁带半导体材料(如 SiC 碳化硅、GaN 氮化镓)器件也开始逐步应用,每一次升级均能实现大幅的功能扩展或性提升。可以说电力电子半导体器件是按照三五年一小代、二十三十年一大代的步伐在快速迈进。可以预见,在未来数年内采用电力电子半导体器件的固态变压器的发展速度也将快于传统的变压器,采用固态变压器技术将有利于进一步降低数据中心供配电系统的电力损耗,提高可靠性。

3.ICT 设备节能技术

ICT 设备的高效节能技术包括:全闪存化存储、全光纤化网络、无损以太网络等,都可应用于数据中心节能提效。

全闪存化存储:在相同的容量下,闪存相较于 HDD 的电力能耗降低 70%,功耗大幅降低,能够进一步压缩产生同等业务输出的总能耗,同时占用空间节约 50%。

全光纤化网络:用光纤替代传统的铜芯通信线缆可以大幅提高网络的高比特数据传输能力以及大吞吐量的交叉能力,并且传输距离更长,布线也更加灵活。随着全光网络的推进,节约了大量用于传统通信线缆中的铜、铝等金属材料,而光纤中所采用的玻璃或塑料等芯材制造过程能耗更少,尤其是这类材料耐腐蚀性能更好,寿命更长,在长期角度能够减少运维产生的成本与能耗排放。

网络设备节能:采用单板级相变散热技术和毫秒级切换电源模块技术的数据中心网络交换机,能耗降低约 50% 的能耗。

全无损以太网络:传统以太网络在数据传输中采取“尽力而为”的方法,是“有损”的。将计算、存储、高性能计算网络统一承载,0 丢包无损以太网络比传统以太网络最高可提高计算效率 17%,缩短整体计算时间。

4.运营运维智能化管理技术

通过 AI 技术能够优化数据中心基础设施管理。如制冷系统能够通过 AI 优化自身的运行状态,也能根据 IT 业务负载需求变化进行及时寻优,供电系统能够主动预测和自动识别报警,以便及时作出响应。借助 AI 技术可以最大限度实现数据中心的自动高效运行,减少由于资源调配不善或人工干预不及时而导致的资源浪费。

本文标题:从数据中心建设阶段和运营阶段整体降低碳排放

本文链接:https://www.blueocean-china.net/faq3/261.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。