为什么数据中心的能耗永远不会下降

数据中心已经成为能源的重要消费者。为了应对数据中心及其服务器的激增,人们大力推动降低所有数据中心组件的能耗。

经过这么多努力,数据中心的电量真的会下降吗?答案是否定的,尽管能源效率有了巨大的提高。

Arm基础设施业务线产品解决方案副总裁Dermot O’Driscoll表示:“在21世纪20年代,保持数据中心的能耗持平将比以往任何时候都更加困难。”。“一些预测表明,如果没有实质性的创新,数据中心的功耗可能会增长2倍到7倍。”

在新基础设施和全球总体发展的推动下,工作量将大幅增加。“人工智能、5G和物联网推动了对数字服务的需求,与此同时,新兴经济体正在建设数字基础设施,以帮助缩小数字鸿沟,”O'Driscoll说。

预期的功率降低可能会使功率不会像在数据中心内完成的工作那样快速增加。这意味着更高效的处理,并且可以控制能耗。但它不太可能彻底降低能耗。这就提出了一个问题,即所需的额外能量从何而来,以及是否可以去碳化。

这一切都是在数据急剧增加的背景下发生的。“世界上创建的数据有一半是在过去两年中创建的,”Ansys电子和半导体业务部门主管Rich Goldman说。据推测,我们正在收集所有这些数据,以便对其进行一些处理。

为了减少数据中心消耗的能源,人们付出了巨大的努力。这个拼图有很多块,它们都在引起注意。粗略地说,最显著的影响因素包括服务器本身、数据中心内部和之间的互连,以及防止过热所需的冷却。

每一部分的具体贡献取决于所执行的特定工作负载。机器学习训练和比特币挖掘是能源密集型计算的两个例子。

考虑到从长远来看正在努力减少所有这些,人们可能会认为数据中心能耗的持续增长可能会被抑制,然后降低。总的来说,这不太可能发生。

提高能源效率

所有的节能措施都有一个目的——在一定的能量下做更多的工作。这对于计算机来说是显而易见的。只要单位能量所做的功增加,效率就会提高。

计算效率肯定提高了。挑战在于,尽管我们现在可以用更少的能量做同样的功,但要做的净功却在大幅增加。

但到目前为止,我们能够实现的效率提升非常有效。虽然有观点认为数据中心的能耗正在以指数级的速度增长,但情况可能并非如此。

“从2010年到2018年,数据中心的工作量增加了六倍多,”Cadence解决方案和生态系统高级集团总监Frank Schirmeister说。“互联网流量增加了10倍,存储容量增加了25倍,而数据中心能耗变化不大,仅增长了6%,达到205TWh。”

总体而言,全球约2%的能源流向数据中心。Synopsys的员工产品营销经理Priyank Shukla说:“2020年,数据中心的总用电量约为300至440TWh”。“这可能会为整个伊朗国家提供电力,但不包括比特币开采。”

Schirmeister表示,能源消耗需要结合实际情况来看待。“我们实际上需要一个不同的指标来定义我们所说的,因为通信、计算和存储的增长比能源消耗的增长要快得多。”

今天使用的一个指标是电力使用效率(PUE),这是一个总的衡量有多少能量流向开销的指标。它是用总能量除以计算量。理想值为1意味着根本没有额外开销。

“如今,数据中心的运行效率为1.08到1.12 PUE,这意味着在进行数据处理时消耗的总功率仅比总功率消耗少8%,”Shukla说。

确切地说,什么被排除在开销之外有些模糊。它涵盖的一个要素是进入大楼的电线和流入服务器的电力之间的配电系统中的任何损失。

英飞凌的营销、电源管理、电源和传感器解决方案业务部门主管Rakesh Renganathan说:“这对我们来说意味着,我们必须制造更高效的电源。”。“仍然有一些创新可以让更高效的电源更接近处理器。”

然而,随着更多的电力输送到每台服务器,我们无法增加电力基础设施的规模。Crocus系统和应用工程副总裁Anuraag Mohan说:“数据中心的电源继续推动更高的功率密度,这意味着在相同的物理尺寸下有更多的功率。”。需要更高性能的传感器来管理更高的密度,并确保更高效地使用能源。

冷却和照明也包括在PUE开销中,尽管冷却部分仅包括整个建筑的冷却,而不包括服务器风扇。

互连

在衡量实际完成的工作时,计算应该占主导地位。其他一切都发生在计算服务中。其中一个主要的影响因素是移动数据的成本。

Shukla说:“互连约占总功率的27%,处理约占20%。”。

其他人则指出了类似的趋势。Rambus的著名发明家、研究员Steven Woo说:“我们看到,在这个庞大的电力预算中,越来越多的数据被转移到各地。”。“人们并不总是想到的片上数据移动也在消耗更多的能量。”

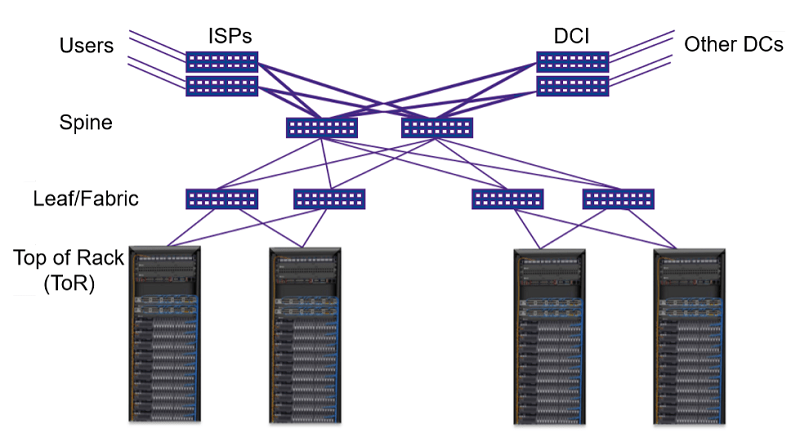

降低这种功耗的一种方法是使用具有更多端口的网络交换机,即所谓的高基数交换机。这允许在一个盒子内进行更多切换,减少了到达更远目的地所需的跳数。带有256个端口的较新交换机应该有助于实现这一点。

图1:数据中心的网络。通过增加交换机中的端口数量,可以在一个盒子中建立更多的连接,这意味着到后端的跳数更少。资料来源:Synopsys

有了所有这些联系,SerDes的电力尤其增长了很多倍。SERDE是两种基本互连技术的一部分。首先,它们是PCIe的固有特性。承载PCIe流量的物理线路使用SerDes技术,这方面可以从最新一代PCIe中受益。“如果您使用PCIe 6,业界预计您将节省30%的电量,”Shukla说。

使用可插拔模块时,光纤连接也需要SerDes技术。这些模块插入服务器的外部,光信号在那里被转换成电信号,最终传输到CPU。电子“最后一只脚”使用SerDes技术。

降低互连功率的一种方法是从PCIe电气互连转移到更多的光学互连。虽然光纤是典型的长途传输方式,在中距离(如数据中心之间或校园内)也在增长,但在相对较短的距离内,它尚未在建筑物中得到利用。

但在这样做的同时节约能源可能需要更多的步骤。向相干调制的转变可能会抵消由于需要额外的数字信号处理而节省的电能。虽然长时间连接会断电,但短时间连接是否会断电尚不清楚。

此外,通过使用共同封装的光纤将光纤一直传输到服务器,消除了连接的SerDes分支,可以进一步降低功耗。

冷却

数据中心的另一个主要电力开销是冷却。出于记账目的,冷却似乎分为两个部分。设施冷却——例如,整体空调进入PUE的非计算部分。但服务器在计算部分,它们有本地风扇或其他冷却基础设施。

冷却占了电力的很大一部分,但它是用于一些不起作用的东西。冷却只是防止计算硬件烧坏。GRC的产品营销总监Larry Kosch说:“数据中心所有用于冷却的电力所占的比例可能会有所不同,但我认为平均比例在40%到45%之间。”。

一般来说,冷却分布更广的电源比冷却单个炽热的芯片更容易。“在功率集中在一个很小的区域的200瓦芯片上冷却是一回事,”Woo说。“如果你能以某种方式将这200瓦的功率分配到多个芯片上,那就另当别论了。通过将其分配,从冷却的角度来看,这会使问题变得更容易,因为功率密度要低得多。”

目前有几种减少冷却的方法,其中一些涉及液体。“现在有更多的芯片使用液体冷却,例如,他们有一个散热器,它接触到芯片,散热器是空心的,”Woo 继续说。“他们所做的是让液体流过散热器,然后吸走热量。”这需要机架内的额外基础设施来输送和回收液体。

他补充道:“人们对所谓的浸入式冷却也更感兴趣,在这种冷却中,你可以直接将电子板浸入电惰性流体中。”。

液体可以更有效地转移热量。Kosch说:“浸入式计算每个机架的密度(每个机架100+千瓦)很容易超过风冷机架(每个机架约15千瓦),因为它能够以高效率和最小或无水损失的方式冷却信息技术设备(ITE)。”。

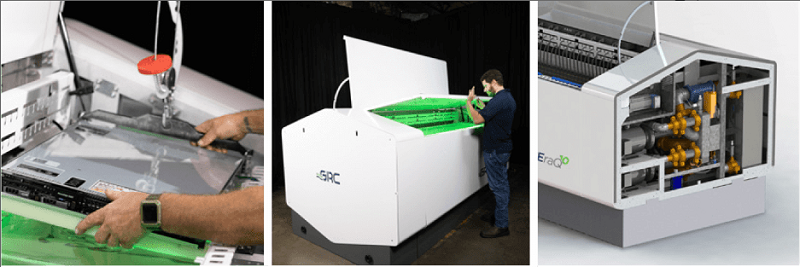

一种浸入法被称为单相浸入法,完全依赖于冷却剂的液态阶段。冷却液循环以促进冷却。

另一种方法被称为两相浸入法,之所以这样命名是因为冷却发生在冷却剂的液态阶段和汽态阶段。服务器浸没在液体中,但液体在芯片表面沸腾,上升的蒸汽作为传热机制。据称,自然对流过程可以减少对泵和其他基础设施的需求。

用液体包围电子设备是不直观的,但如果液体是绝缘体,就不会发生短路。如果化学成分正确,则不应出现腐蚀或降解。

Kosch说:“虽然可以浸入设计为风冷的ITE(只需关闭风扇、调整固件等微小修改),但快速增长的采用率已经产生了足够的需求,因为ITE原始设备制造商已经将浸入式服务器推向了市场。”。“众所周知,微软采用了两相浸入式冷却,而亚马逊则依赖于直接到芯片的冷却。单相浸入式冷却在这个市场上有一席之地。”

图2:单相浸入式冷却机架。刀片服务器垂直插入电介质中。这里展示的是移动数据中心机架。资料来源:GRC

更平淡无奇的是,在优化冷却时,位置也很重要。Facebook在俄勒冈州的普里内维尔设立了一个数据中心,部分原因是气候较冷。“它们可以通过管道进入温度较低的室外空气,这使它们更容易冷却,因为它们不需要对空气进行太多冷却,”Woo说。

在极端情况下,微软有一个名为Natick的演示项目,在该项目中,服务器被放置在一个密封的容器中,该容器被淹没在海洋中两年。“他们将一个小型数据中心淹没在海洋中,以获得一个非常好的热控制环境,”Woo解释说。“你周围是恒温的水,它有巨大的吸热能力。”

服务器不仅存活了下来,而且更有效的冷却带来了更高的可靠性——相当于陆地服务器故障率的八分之一。

更高效的计算

虽然这些努力的部分目标是将更大份额的能源用于实际计算,但这并不是真正的结局。真正的目标是做更多的工作,这不仅需要更多的计算能量,还需要更高效的计算。

这种情况可能会发生,但有三个更大规模的改进将产生更大的影响。

一个是发明新的CPU体系结构的能力,这种体系结构本质上更高效。这不仅仅是低功耗电路设计,而是重新思考如何进行计算,以及如何在计算执行时减少数据移动的频率。

“现在出现了新的处理器架构,可以节省处理能力,”Shukla说。

特别是机器学习正在迅速成为一个巨大的能源用户。但是机器学习有两个方面。最常见的是推理——使用已知的算法来解决问题。但这可以非常有效地完成——如此之多,以至于在某些应用中,即使在微瓦级也可以在边缘完成。

模拟电路正在利用诸如内存计算之类的想法来帮助其中一些架构。“乘法和累加可以在模拟中完成,”Shukla说,他暗指存储器可以用于模拟计算的方式。

真正的机器学习能源消耗是培训,而这几乎完全是在数据中心完成的。在训练新的机器学习模型时,需要继续努力降低能耗。

最后,在更远的未来,光子计算有希望。光子“电路”进行的计算名义上是无损的。所消耗的能量主要用于产生激光。光发生的变化可以用很少的能源成本来管理。

“Lightmatter声称功率降低了30倍,”Shukla说。该公司正在开发光子计算。

再加上光子学体系结构可能发生的变化,以及互连中光子学的使用增加,这也有助于降低单位计算工作量的能耗。

实际能源限制

虽然很容易描绘出能源使用量无休止增长的画面,但对于给定的数据中心来说,这种增长是有实际限制的。

一个方面是监管。当新的数据中心被允许时,它将从电网中获得一定数量的能源——根据可用于满足数据中心和市政当局其他需求的能源。

“你愿意建立数据中心的城市或地方显然让数据中心变得越来越大,”Woo说。“但是必须有一些限制,而这个限制将由你将要建立数据中心的地方的政府设定。”

另一个限制是建筑施工时内置的容量。具有前瞻性思维的建筑师将始终为增长做好准备——即使预计允许的能源使用量可能会增加。但一旦这座建筑完工,增加配电能力可能不是一件小事。

这在一定程度上限制了现有数据中心所能消耗的能量。因此,更大的增长不是来自使用更多能源的建筑,而是来自新数据中心的建设。

能源

虽然近来我们的能源消耗越来越大,但事实仍然是数据中心的电力仍在增长——只是速度更为缓慢。考虑到未来十年预计会有大量额外的数据处理,没有人相信净能耗会下降。

随着越来越多的设备连接到互联网——尤其是电动汽车和自动驾驶汽车的连接——数据传输预计将大幅增长。至少,这意味着需要移动和存储所有这些数据。

但如果这些数据不经过计算,就没有价值。分析和其他操作,其中许多涉及机器学习,将有更多的数据可供操作。这意味着需要完成的工作总量将大幅增长,可能超过效率的提高。

这种能量从哪里来?有两个挑战。首先是产生更多能源的能力——最好是在数据中心附近。但是,在我们也在努力减少能源生产的碳化、依赖可再生能源并摆脱化石燃料的时候,这是必要的。

这是一个更大的挑战。我们究竟如何实现这一目标尚不清楚。尽管数据中心在全球用电量中所占的份额仍低于10%,但这是一个显而易见的部分。可以说,与其他许多可能确实降低净能耗的部门不同,它将继续增长的事实意味着它在总能耗中的份额将增长得更快。

“人们已经准备好做一些事情,比如把他们的数据中心放在靠近水力和可再生能源的地方,在那里他们可以从附近的东西获得大量能源,”Goldman说。

随着越来越多的人关注数据中心的这一方面,新的解决方案可能会出现。“关于如何去碳化,我有明确的道路吗?”Schirrmeister问道。“还没有,但聪明的工程师会解决这个问题。”

结论

归根结底,要做的工作太多了,以至于没有迹象表明在可预见的未来任何时候能源消耗都会下降。我们可能会找到更友好的能量来源,但胃口不会轻易平息。

如果要在降低总体能耗和加大能耗之间做出选择,选择将是显而易见的。芯片设计师每天都会做出同样的选择。“对于每一个新的过程,我们都有一个选择——让它更强大,或者降低相同功能的功率,”Goldman说。“我们从不追求降低功耗。我们追求更强大的功能。在数据中心,我们看到了类似的东西。”

Woo总结了半导体开发人员的底线:“对于像我们这样的半导体行业的人来说,可行的项目是让个人计算更节能——不管怎样。”然后,数据中心设计师将尽可能多地使用它。

本文标题:为什么数据中心的能耗永远不会下降

本文链接:https://www.blueocean-china.net/faq3/654.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。