数据中心冷却效率的策略重要性

数据中心冷却效率的策略重要性

首先,确保你数据中心运行的温度不会过低。美国采暖、制冷和空调工程师协会(ASHRAE)自2004年以来一直在跟踪他们所推荐的数据中心定义类型的允许温度。

在2004年,最大的高端温度设定在摄氏25度。到2008年,已经上升到摄氏27度。到2011年,ASHRAE推出了一系列数据中心类型,尽管他们建议将数据中心的运行温度维持在摄氏27度,但他们提高了最高允许温度——温度增加将导致设备故障率增大的最高值:摄氏45度。防范风险需要采取相匹配的措施,而较高的数据中心运行温度则需要少得多的冷却资源,这将导致更少的计算机机房空调(CRAC)机组的需求和更少的能源需求。

最简单的省钱方法是减少数据中心运行的CRAC数量。如果只需要一半的冷却量,那么,关闭一半的CRAC将直接带来能源成本和维护成本的节约。使用变速代替固定速度的CRAC也同样是是另一种用以实现这一目标的方式,在这种情况下,所在空调制冷机组设备只保持所需的温度速度运行。只有当这些空调机组保持100%的运行时,才能达到其最有效的水平。而一些变速系统在部分负荷率的情况下,不能运行完全优化操作。

以这样一种按照固定比例运行标准的方式建立CRAC的“热惯性”是符合成本效益的。在这种情况下,数据中心以大大低于目标温度标准冷却运行机组,然后将其关闭。此时数据中心的运行温度允许逐步升高,直到其达到一个确定的点,CRAC机组将重新开启。通过此过程,各机组都能够满负荷运行,并且能够达到他们的最高运营操作效率。当他们被关闭时,他们也是非常符合节能高效运行标准的,因此也就没有被浪费的能源。

然而,采用简单的容量的方法来进行数据中心的冷却仍然是浪费的,无论空气怎样进行初步冷却,大部分冷却的空气将无法充分的接触任何IT设备进而带来任何有效的冷却。

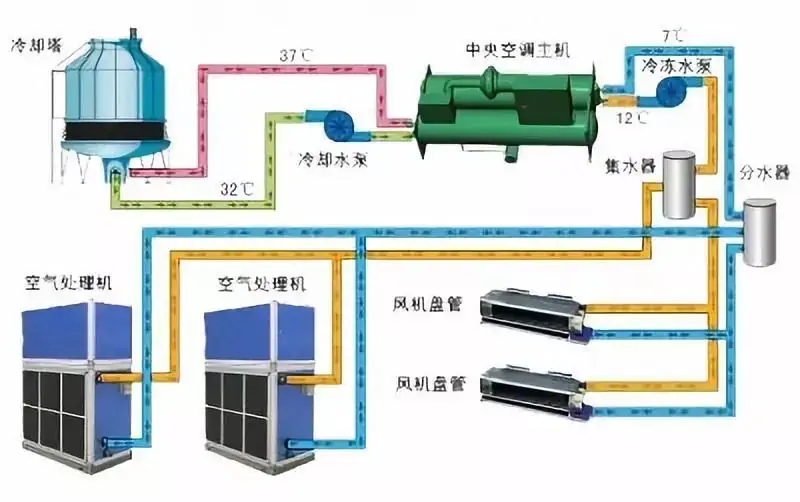

对于更彻底冷却液,有更加完全的系统。诸如Iceotope和GreenRevolutionCooling这样的公司即提供这样覆盖整个服务器——或其他IT设备的系统,有一个非导电但高导热液能够从设备组件中带走热量。这些系统是那种运行数百个核心的图形处理单元(GPU)服务器的理想选择。或用于大规模计算高密度的热运行的CPU,他们每次可以处理超过100千瓦。基本上在机架一侧是封闭的。一些系统可以在华氏140度(60摄氏度)的液体温度条件下运行。

风扇在这种系统中是不必要的,从而节省了更多的能源。由于所使用的液体在去除热量方面比空气或水更好,硬件可以运行在更高的温度条件下,并且允许从液体进行热回收以供给给其余的建筑。

数据中心冷却降温之后的措施

这些系统提供的主要冷却途径会根据各地不同的需求和不同的环境条件而不同。监测必须到位,以便狠狠的监督所有数据中心的散热。

这便是数据中心基础设施管理(DCIM)发挥用武之地的时候了。热传感器和红外探测器可建立一个地图的热点。计算流体动力学可以在某些特殊情况下查看新的冷却流以及不同入口温度如何与不同的系统兼容。

DCIM一旦到位,持续监控,确保迅速识别热点,允许系统被放缓、关闭,并视需要进行更换。在许多情况下,突然出现的热点表示在设备中即将发生故障。能够在这些故障发生之前迅速进行定位,意味着保证了系统的正常运行和可用性保持较高的水平。

全球数据中心业界正在持续不断的发生着变化,用旧的冷却方式肯定是相当浪费资金的。将新的准则与新的方法相结合,能够帮助您的数据中心在维持更少的资金投入的情况下,享有更有效的冷却,同时也节约了数据中心的运行和维护成本。

本文标题:数据中心冷却效率的策略重要性

本文链接:https://www.blueocean-china.net/faq3/413.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。