双碳时代从风冷、液冷技术浅析数据中心节能

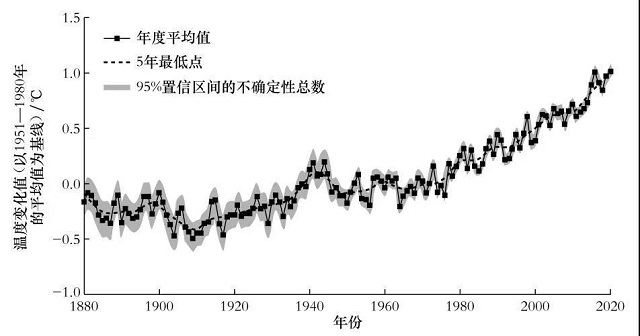

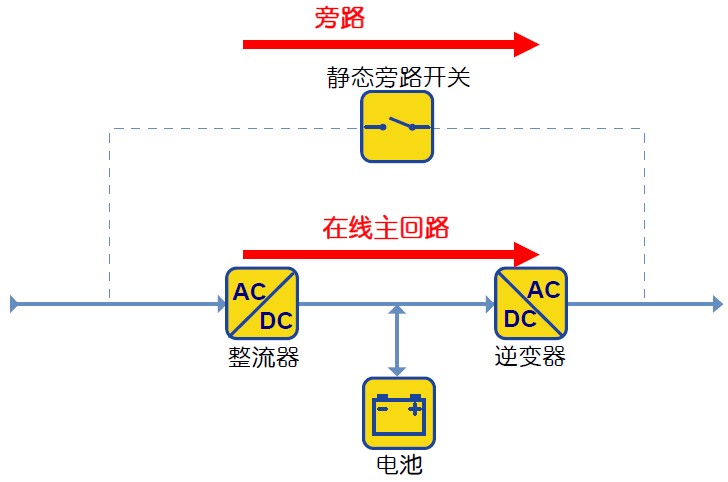

对于数据中心而言,空调系统是为降低服务器CPU温度的必配系统,若空调系统供冷中断,则数据机房送风温度降急剧升高,造成服务器高温宕机,影响业务安全。除此之外,根据Uptime报告指出,全球大型数据中心年均PUE为1.59,暖通能耗占比为30%。因此,空调系统能耗是制约数据中心PUE值的关键因素。 而据中国信通院统计各国家和地区相继公布碳中和的目标和承诺,美国政府通过DCO数据中心优化倡议、FDCCI美国联邦数据中心整合计划、FITARA联邦政府信息技术采购改革法案等一系列举措整合和关闭数据中心,已经实现数据中心数量减少7000个,占比约50%。数据中心平均PUE从2.0降低到近一半大型数据中心达到1.5甚至1.4以下。2020年欧盟数据中心能源效率行为准则的最佳实践指南和欧洲数据中心能源效率现状白皮书:规范了PUE、SUE、DCIE等指标。欧洲数字战略和塑造欧洲的数字末来中表示欧洲需要在数据中心和整个电信行业都提高能源效率并使用更多可再生能源,ICT基础设施和数据中心应确保在2030年之前达到气候中性 (climate neutral)。2050年成为世界第一个实现气候中性的大陆。这些国际上数据中心的目标和节能减排实例已经向数据中心行业的发展和未来提出更加严苛的要求和期望, 绿色、低碳、节能将是数据中心未来发展恒久的主题。

回顾数据中心冷却技术的发展

一、风冷冷却技术

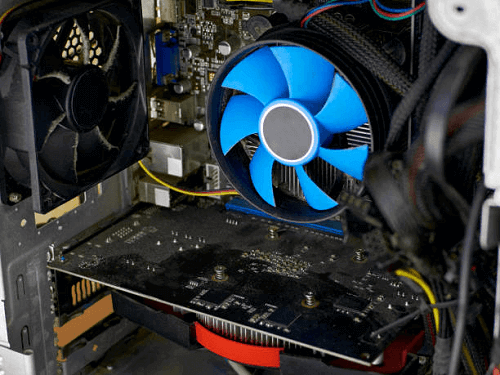

常见的数据中心服务器CPU冷却形式为风冷,风冷的优点是散热器与基板(CPU)的装配具有标准化特征,虽然散热器的种类形式各异,但在组装方法上基本可以做到标准化或规范化,有利于大规模生产。而常见的风冷末端空调的布置形式主要有:房间级地板下送风、行列间冷/热通道封闭、热管背板等。

在IT设备中,服务器有内部的风扇通风功能,将设备散发的热量进行导流而不具备制冷能力,除此外我们需要部署机房冷却系统,也就是精密空调,以保障服务器良好运行。而就数据中心未来绿色节能的发展趋势来说,在保障服务器良好运行的基础上,努力做到更低的PUE才是大势所趋。降低PUE意味着降低数据中心的能耗,从制冷技术层面来说数据中心要想做到这一点,无论哪一种制冷技术都是为了让冷却介质在末端尽可能的贴近设备,减少换热次数,以便于介质更加高效的与设备进行热交换,从而提高换热效率、降低冷损失。

1、房间级空调采用的弥漫式送风,可谓是“大水漫灌”。从气流组织管理的角度来说,在机房中安装的集中空调由于没有合理导向将冷气精准的输配到发热设备,只有部分冷介质与IT设备产生的热量进行热交换,这样的气流组织形式只能浪费其余的大部分冷量。这样的房级空调对数据中心能耗损失较大,进而影响的PUE值只能在2.0~2.5之间徘徊,也就是说这样的数据中心2度的电能最多只有1度用于IT负载。

2、老旧的数据机房以及通信间一般使用房间级地板下送风空调,房间级地板下送风空调一般集中布置在空调间内,通过架空地板形成静压箱,冷空气通过架空地板上吹后,经过服务器将CPU降温后回到空调回风口。房间级下送风空调因输送距离较长,且在输送风路上个点静压不同,呈先小后大再小的形势,以此容易造成机房局部热点的产生。以此,在使用过程中常将房间级空调的风机转速调大,温度调低,减少局部热点的产生,因此往往造成能枆浪费。

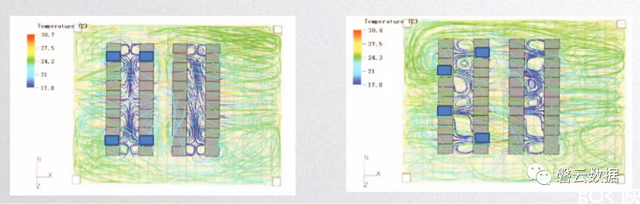

3、新建的数据机房大多采用行列间空调冷通道封闭的形式,近年也有不少工联网企业提出行列间热通道封闭的形式。与房间级下送风空调相比,采用行列间空调冷/热通道封闭的形式可以获得较高的能效比,使冷量可以更加集中,气流组织更加均匀。对于行列间空调,机柜的布局方式对气流组织有较大影响,近年也有很多专家通过CFD模拟对机柜的布置形式对气流组织的影响做了研究。图中所展示的,合理的机柜布置可以让气流组织更加均匀 ,冷气更容易进行热交换。图示中左侧为对立布置服务器的机柜的气流组织CFD模型 ,右侧为交叉布置服务器的机柜气流CFD模型,不难看出对立布置服务器的机柜气流组织较为均匀。前面我们提到服务器内部是有内置的风扇来辅助服务器进行散热,而内置风扇对气流的调节都是线性的,一般风扇会根据环境温度和温差进行启停维持服务器内部温度在合适范围。之所以不能忽略服务器内部的风机对气流组织的影响,是因为服务器运行过程中风机产生的能耗也算IT负载能耗,降低PUE值不能只关注分子,而忽略分母,降低整体能耗的同时也要想办法降低IT能耗。

二、液冷冷却技术

任何一项技术的迭代和更新优化都是权衡技术本身优点和效益而产生的,而液冷发展的三个核心原因正是风冷冷却无法做到且对于数据中心未来发展更高期望的具体表现:

1、芯片热功率已经达到风冷极限350w-400w。

2、国家对数据中心PUE提出了更高的要求,数据中心是能耗大户,2015年我国数据中心能耗高达1000亿千瓦时,降低PUE对节能减排大有裨益。

3、液体比空气散热的优势明显;同体积液体带走热量是空气的3000倍、液体导热能力是空气的25倍、同等散热水平时,液体系统噪音的比风冷降低10~15db、液冷系统约比风冷系统节点30%。

而液冷冷却技术是如何做到这些的呢,还是那句话无论哪一种制冷技术都是为了让冷却介质在末端尽可能的贴近设备。

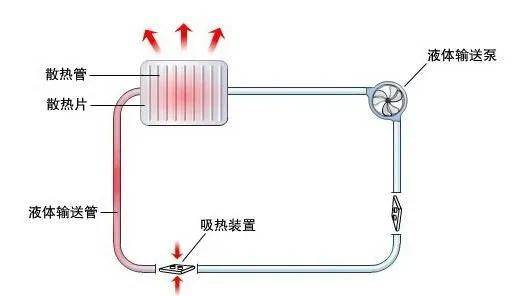

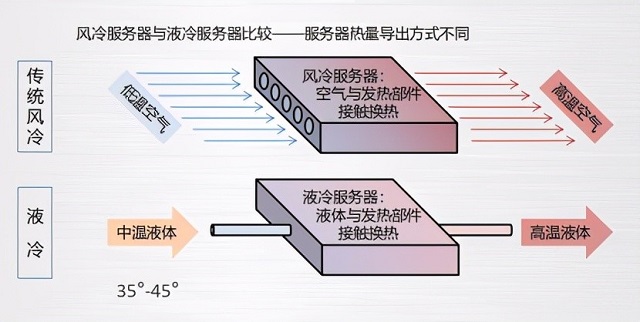

现有的液冷技术主要有紧耦合式(间接接触)液冷技术及浸泡式(直接接触)液冷技术。紧耩合式液冷技术就是用管道将冷冻液输送到机柜内部的发热元器件附近甚至紧贴发热元器件的散热片。浸泡式液冷技术就是将服务器浸泡于一种特殊的矿物油或氟利品中进行降温,此系统对矿物油及氟利昂化学成分、密闭和净化条件要求非常高。一般单机架功率超12KW建议采用液冷方式,相对于风冷而言,液冷可以效率更高。但液冷服务器均需定制,初始投资高,对建筑物称承重有一定要求,且后期维保投入大。如华为可拔插型的水冷板液冷服务器,均需要华为专配的蒸馏水。其实这也就体现出液冷技术的一些弊端,比起常规的风冷服务器而言,特殊液冷的服务器会对日常的机房运维工作带来一定困难。

冷板式液冷是一种紧耦合式(间接接触)的液冷技术主要通过3种核心部件来实现末端更加贴近设备,它们分别是cold plate(冷板)、manifold(分歧管)、CDU(冷却分配装置)。冷板相当于冷却系统中的“皮肤”,对于高密散热的服务器而言,服务器内部的散热空间是极其狭小的,这就意味着需要更加贴近服务器内部发热元器件的冷板贴合进行高效的换热。而分歧管则负责输送冷却介质分布在服务器两端同时连接冷板,相当于人体中连接心脏和人体组织的“血管”,那么冷却分配装置就相当于冷却系统中的“心脏”,保证冷却介质在冷却系统中的循环效率。理想状态下的液冷冷却技术在精准化的制冷过程中产生PUE可达到1.01~1.2,可大幅降低数据中心的能耗。目前业界比较广泛的采用液冷技术大多是间接液冷(板式),也有在使用直接液冷模式,如阿里就是采用的单向浸没式的液冷制冷技术。由此可见液冷技术对于数据中心来说,在可预见的未来液冷技术将极具规模的占据制冷系统的一席之地。

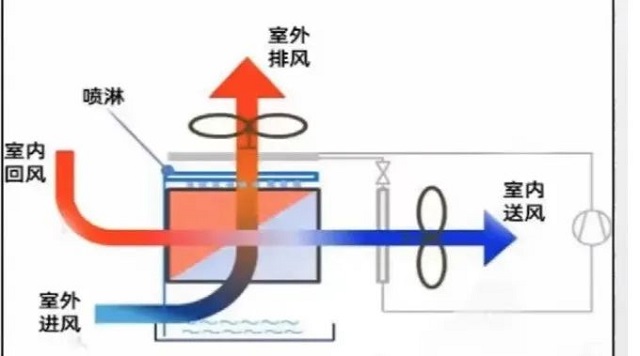

三、间接蒸发冷却技术

其实提到绿色节能的制冷技术,在大学课程及行业应用中都会涉及和应用到间接蒸发冷却技术,它是一项利用水蒸发吸热制冷的冷却技术。简单的说,原理是将室外新风与循环水直接接触后等焓降温后间接的通过换热器带走机房热空气中的热量,从而对机房进行降温。间接蒸发冷却技术相对于水冷空调而言,减少了冷水机组、水泵、冷却塔等设备能枆,在低温环境下可以高效的提供自然冷源给机房供冷,因此,在北方寒冷区域使用,可以有效降低空调能耗。但南方高温高湿地区则不适用。这种制冷技术存在的弊端就是有着比较强的地域性,也就是和当地的气候条件关联性比较紧密。业内应用并不广泛,但是不影响这项技术在未来建设更多绿色节能的数据中心时成为甲方和工程师们考虑的方案之一。目前这项冷却技术有着较大的地域气候壁垒,但是不妨碍行业建环暖通专业工程师和行业建设方对它的技术突破和尝试。间接蒸发冷却技术在南方地区也有使用的案例,目前也有数据机房在尝试使用液冷加间接蒸发冷却技术。如仪征的腾讯机房,以及已经在建设的南京佳力图机房。但江苏地区夏季不属于高温高湿地区,它的自然冷源利用时长 一般仅2~3个月,因此,在非自然冷源期间需利用电能制冷进行冷量供给,因此在南方地区单纯的利用间接蒸发冷却技术未必可以实现节能。液冷技术的出液温度一般50℃,而南京地区最高湿球温度28.5℃,因此完全可以利用蒸发冷却技术与液冷技术相互结合,减少电能制冷的使用,从而实现数据中心空调系统的节能。

技术革新永远没有尽头只会愈加精益求精,数据中心行业的发展应该与时代同频共振。自2020年开启的双碳时代已经走过快两个年头,绿色、节能、低碳的时代发展主题无论对于哪一个行业都是不可抗拒的,数据中心更应该走在绿色行业的前排,加快降低碳排放步伐,引导好绿色技术创新,提高产业和经济的竞争力,做好绿色、节能、低碳生产的排头兵。

本文标题:双碳时代从风冷、液冷技术浅析数据中心节能

本文链接:https://www.blueocean-china.net/faq3/346.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。