液冷技术助力数据中心绿色节能降低PUE

数据中心绿色节能刻不容缓

在数据中心市场成熟的国家中,平均2%-3%左右的全国电力被用于数据中心。虽然近年内大型和超大型数据中心的建设规模持续增长,技术升级以及空间规模的增长提高了计算资源的利用效率,但仍然是电力资源的消耗大户。数据中心的日常电力消耗占用了大部分的运维支出,降低运维成本和提高能耗的利用效率刻不容缓。

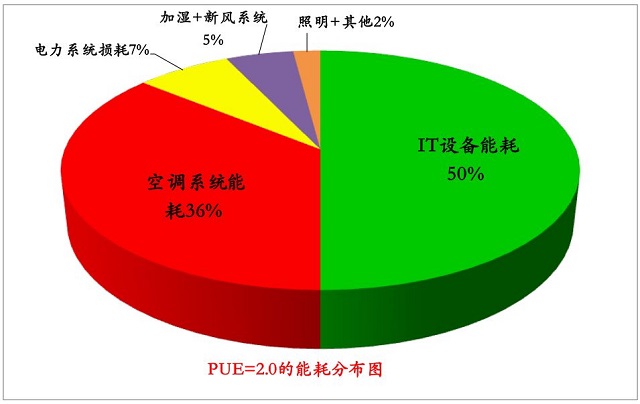

能效的提高体现在PUE值的进一步压缩,即尽量减少用于IT设备工作之外的能耗,如热管理、配电、照明等系统,其中热管理占了这部分能耗的绝大部分。在传统数据中心中,用于热量管理的电力占到了总电力消耗的25%-30%左右,也就是说,为了满足数据中心的散热需求,需要使用占一个国家总耗电量的0.5%-1%左右的能耗来进行热管理。

然而随着CPU与存储等关键器件的快速演进,芯片技术与工艺的进步使市场上出现了更多高性能且高功耗的处理器。目前用于数据中心的CPU功耗在165W至275W,在未来将提升至400W以上。并且AI模型训练对高功率并行计算产生更大需求,单位面积发热量更高的AI芯片数量增加,进一步推高了服务器的功耗。处理单元的数量增加与单一处理单元的功耗提升速度远超过由摩尔定律所预测的单位瓦特算力提升,使服务器的单位发热量迅速提升,芯片级热管理的不足将成为限制服务器性能发挥的瓶颈。

除单一服务器的发热量增加之外,每个机柜之内的服务器数量也在增加。平均机架功率密度已经从十年前的2-4KW/机架增加到了如今的7-10KW/机架,未来有望增加到25KW-50KW以上。对于希望提高空间利用效率而密集部署机架的数据中心而言,机房内的热管理状况一定程度上决定了数据中心的算力上限。即使出现了应用虚拟化、容器化等最大化利用物理服务器的新技术,仍然将成为影响整个数据中心负载率的主要因素。

这些趋势使得下一代高算力数据中心的散热需求将远高于当前,寻找算力、PUE、成本三者的平衡点将更加困难,与追求的高能效目标产生了矛盾,为了提高能源利用效率和改善生态环境质量,各国都对未来一定时期内数据中心的PUE提出了更低的目标值。为了达到这一目标,需要在保证IT设备正常运转的同时,尽量采用更加高效、低能耗的先进热管理手段,降低IT设备之外的能耗以及运营成本,为未来更节能且低成本的无人值守数据中心打下基础。

高效节能热管理降低PUE:液冷技术

从热管理角度上缓解算力与能耗的矛盾,需要将现有热管理技术向节能高效方向进行升级。以目前机柜与服务器的冷却方式而言,使用空调机组对IT设备风冷是主流方案,技术成熟但功耗较高,节能升级的空间有限。随着设备的集中化与功率密度的提升,为达到正常运行功率下的散热效果,空调制冷机组的功率也要相应大大提高。而为了保证数据中心的安全稳定运行与合理的PUE区间,空调制冷机组的高功耗成为了限制高性能IT设备实现性能的主要因素,单机柜功率上限被限制在25KW,更高则受制于空调功率而无法运行。

在机柜与算力密度较低的传统数据中心中,除空调风冷方案外,也可以因地制宜,利用自然冷源设计更低能耗的风冷方案,自然风冷优势在于因地制宜,利用了天然冷源对IT设备进行散热,减少制冷系统对电力的需求,具有非常高的能效比。整体而言,无论是空调风冷还是自然风冷,都以空气流作为热量的载体,为了达到较好的散热风路,对于机架设备的密度有一定要求,限制了单机柜密度的提升,已经无法跟上IT设备的功耗与密度提高的步伐。

当单位瓦特算力提升有限的情况下,为了使下一代数据中心的热管理技术足以应对高密度、高算力化的IT设备散热挑战,需要针对高算力场景中传统空调风冷散热的不足之处,加强对芯片等主发热单元的重点冷却,并且尽量减少导热路径中不必要的热量散失。空气作为载热工质已经无法满足这一散热需求,多种以液体为载热工质的冷却方案因而在近年来受到数据中心拥有者的青睐,成为高算力场景中取代空调风冷的重要手段。在过去数十年中,液冷技术却一直用于冷却大型机、超级计算机,和高性能个人电脑。只有在过去五年中,它才被高算力数据中心用于冷却功耗巨大的IT设备,取代空调机组来支持从AI算法到比特币挖掘等高算力应用。

在数据中心场景中,根据冷却液与设备之间接触方式的不同,可以分为以浸没式液冷为代表的直接接触型液冷技术,和以冷板式液冷为代表的间接接触型液冷技术。后者由于成本更低,且部署更加灵活,可以实现板级和柜级层面的制冷,且具备风液混合、全冷板覆盖等创新方案,根据实际情况取代空调风冷和提升机柜的液冷占比,因此更加适用于热密度较高的数据中心。以这类冷板式间接接触液冷为例,主要具备以下优势:

导热能力

特殊配比的液体的比热容更大,导热系数远超空气,与同体积空气相比,可以带走的热量将近3000倍。考虑流速因素,液冷方案的散热能力是风冷方案的25倍左右。因此可以支持更高性能IT设备的正常运转。

工作噪音

泵推动导热液体在密闭管内流动,与传统空调的风路风扇相比,不会产生气流噪音,因此工作噪音较风冷相比降低20-35分贝。对运维工作和周边环境更加友好。

空间利用率

液冷方案的实施带来散热水平的显著提升,使机架和服务器的安装布局可以更加密集紧凑,从而降低数据中心白空间的需求,提高了数据中心整体的空间利用率。

PUE与能耗支出

导热液体管路密闭,与芯片等发热单元直接接触,热量在流动路径中散失更小,同等散热量的耗电量比风冷降低50%左右。更有利于PUE的进一步降低。相应运营成本中电耗支出也相比风冷方案减少。

免空调化

与传统空调风冷方式相比,液冷方案中液体在管路中将热量带至换热设备中与外界冷源进行热量的交换,降低对价格高昂的制冷机组与空调设备的使用程度和依赖,同时也省去了对空调和制冷机组的复杂维护投入,对环境更加友好。

高算力场景中采用液体冷却方案在设计、操作和适用性方面的显著优势,引起了数据中心行业的共鸣。同时液体作为导热工质,与传统空气介质相比存在特殊性,不能用风冷的经验和思路来看待液冷。并且由于在数据中心领域落地时间不长,也需要针对IT设备散热的特点进行调整。

如要在数据中心中成功通过实施液冷达到PUE目标,需要在系统的安全性、智能化程度、标准化以及可操作性等方面达到一些关键要求,包括管路的密封和可插拔性、液体的安全性和导热性、与瞬时功耗的智能匹配以及更高程度的标准化等等。在节约热管理能耗的同时,降低液冷方案在新建和升级数据中心中实施的门槛,提高长期使用的电气安全性,并且从长远角度,促进液冷升级流程方案和产品的标准化,有利于加速技术和市场的成熟。

液冷方案的市场展望

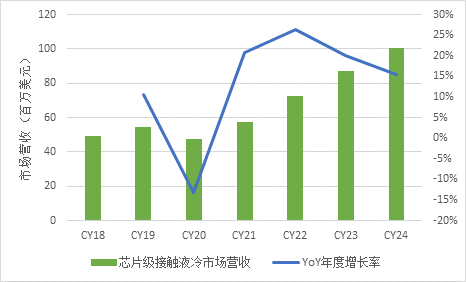

作为较新的冷却技术,液冷方案(芯片级直接接触液冷散热)市场整体规模不大但增速较快,2019年同比增长了11%。但作为一个年轻的市场,产品和供应商体系建立时间不长,相对较为脆弱,因此受COVID-19疫情的影响较为严重,在2020年收缩了13%。同时疫情也让最终用户有更多时间和资源来了解液冷方案的优势、成功案例以及需要克服的挑战,因此液冷方案供应商仍然对这一新市场抱有信心,并普遍认为,当2021年全球疫情开始缓解,液冷市场将迎来复苏和显著的增长。

图1 芯片级液冷市场营收与增长趋势

液冷方案市场营收将在2021年和2022年加速增长至21%和26%,从2019年到2024年,液冷方案市场的五年复合年增长率为13%,市场规模突破1亿美元,在全球数据中心热管理市场中的份额也将从2020年的1.4%提升至2024年的2.3%左右。

总结

能耗是当前数据中心后期运营的最大成本项,要面向下一代提高数据中心的竞争力,就必须面对能耗成本这一关键痛点,通过技术手段提高能源在数据中心中的最大化利用,在提升算力的同时,降低大型数据中心的能源消耗。作为除IT设备外最大的耗电项,热管理在数据中心整体节能中举足轻重。如果成功将热管理的能耗进行改善,数据中心就向节能增效的整体目标前进了一大步。

当前主流的空调风冷方案在下一代大型数据中心的应用中存在瓶颈,一方面限制了IT设备性能和机柜密度的提升,另一方面在能耗方面不占优势,达到制冷效果需要消耗大量能源。因此在未来数据中心升级的过程中,对于通用计算场景,可以部分采用自然风冷的方案,利用冷空气等自然冷源来对IT设备进行更低能耗的高效热交换,在降低PUE的同时,也能带来更加显著的成本效益。对于高算力场景,则出现采用液冷方案来取代部分空调风冷的趋势。液冷方案通过导热工质的改变,能够实现更加精细化、智能化的热管理,有效控制高算力、高密度设备的发热量。也因为这些特点,液冷能够降低制冷能耗的散失浪费,提高能源的利用效率,成为了数据中心实现PUE目标的关键手段之一。

应用于数据中心的液冷尚处于市场成长阶段,实施方案偏向于定制化,一些实际部署仍与传统的空调风冷却相结合,作为混合散热解决方案的一部分在数据中心的一部分机架上应用。也有整个数据中心都使用芯片/服务器级的完全液冷解决方案的实践。数据中心市场需要对液冷等先进热管理技术有更进一步的深入了解和实例佐证,当市场更深体会到液冷方案对高算力场景下降低PUE的技术与成本优势,采用率还将有很大的提高空间。

本文标题:液冷技术助力数据中心绿色节能降低PUE

本文链接:https://www.blueocean-china.net/faq3/254.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。